نویسنده (ها): به سمت تیم تحریریه AI

در ابتدا منتشر شده در به سمت هوش مصنوعیبشر

صبح بخیر ، علاقه مندان به او ،

انتخاب مدل مناسب به همان اندازه مهم است که دانستن نحوه فوریت آن مهم است. در AI چیست، من توضیح می دهم که چرا درمان LLMS همانطور که قابل تعویض یک اشتباه است و اینکه چگونه یک ابزار معیار بدون کد می تواند به شما در جدا کردن اعتیاد به مواد مخدره از تناسب کمک کند.

از آنجا ، ما به جزئیات می پردازیم: یک سیستم چند عامل که اکنون چندین مدل را به صورت موازی اجرا می کند ، روش های جدیدی برای ارزیابی خطوط لوله RAG بدون حدس و گمان و یک راهنمای عملی برای بهینه سازی سریع که می توانید بلافاصله از آن استفاده کنید.

ما همچنین سؤالات بزرگتری را مطرح می کنیم ، مانند آنچه در هنگام تعبیه در محدوده ریاضی یا نحوه ساخت برنامه های AI آفلاین که داده های شما را خصوصی نگه می دارد ، می شود.

بیایید وارد آن شویم!

هفتگی AI چیست

https://www.youtube.com/watch؟v=lx1olcgkzxg

این هفته ، در AI چیست، من به یک موضوع مهم شیرجه می زنم: چرا همه وجود دارد LLMS برابر نیست؟ در حقیقت ، رفتار با همه آنها یکسان می تواند به فرصت های از دست رفته منجر شود. من نحوه انتخاب بهترین مدل برای کارو سپس ، در بخش عملی ما ، از یک ابزار معیار عالی ، آسان برای استفاده و بدون کد ساخته شده توسط Intigrail برای مقایسه LLMS استفاده کنید. علاوه بر این ، ما از سیستم چند عامل که در آن ساخته ایم استفاده خواهیم کرد مقاله قبلی، که از چندین مدل به طور موازی ترسیم می شود. مقاله کامل را اینجا بخوانید یا فیلم را در YouTube تماشا کنیدبشر

-لوئیز فرانسوا بوچارد ، به سمت بنیانگذار AI و رئیس جامعه

بخش جامعه را با هم بیاموزید!

پست برجسته جامعه از Discord

لوکیلاب ساخته شده است BRIDCHKIT ، یک ژنراتور و کتابخانه سریع AI که به کاربران کمک می کند تا با مدل های محبوب AI ، ایجاد ، سازماندهی و آزمایش کنند. این کتاب همچنین شامل یک کتابخانه سرپرست از اعلان های با کیفیت بالا برای ابزارهای مختلف هوش مصنوعی است. یکی از جالب ترین ویژگی ها نتایج پیش نمایش است که به کاربران این امکان را می دهد تا قبل از استفاده از آن با ابزار انتخابی AI ، نتایج مورد انتظار را از هر سریع مشاهده کنند. ابزار را در اینجا بررسی کنید و از یک عضو جامعه دیگر حمایت کنید. اگر سؤال یا درخواست ویژگی دارید ، در موضوع به او دسترسی پیدا کنید!

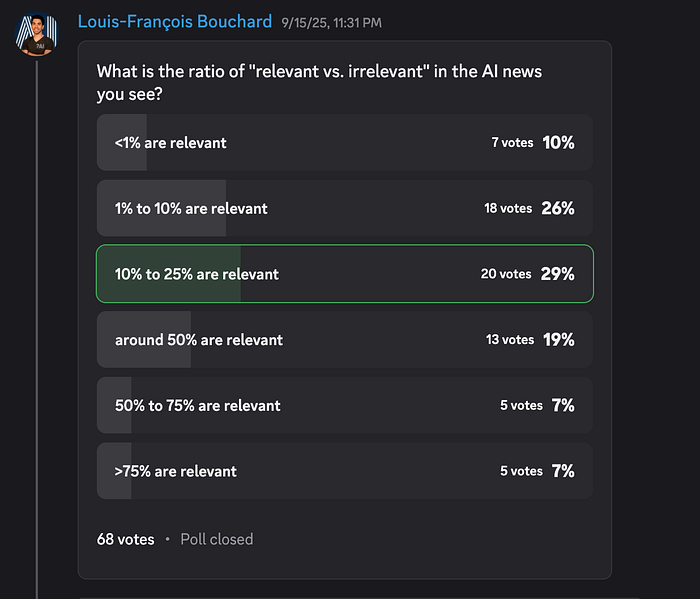

نظرسنجی AI هفته!

این می گوید که تقریباً یک سوم شما گفتید که فقط 10-25 ٪ از اخبار هوش مصنوعی احساس ارتباط دارند. این بدان معناست که اکثر آنچه ما می بینیم سر و صدا است: دور بودجه ، نسخه های نمایشی چشمک زن یا “نسخه دیگر یک مدل دیگر” با تأثیر کمی در دنیای واقعی. اما در اینجا پارادوکس وجود دارد: دفن شده در آن 10-25 ٪ اغلب پیشرفت هایی هستند که واقعاً مهم هستند: معیارهای جدید ، تغییر زیرساخت ها یا مواردی که در واقع گردش کار را تغییر می دهد. در حال حاضر ، چگونه سیگنال را از سر و صدا فیلتر می کنید؟ آیا به معیارها ، صداهای قابل اعتماد ، آزمایش دستی یا چیز دیگری متکی هستید؟ در موضوع به اشتراک بگذارید و به اعضای دیگر کمک کنید تا منابع مرتبط را پیدا کنند.

فرصت های همکاری

جامعه Discord Learn Ai Together با فرصت های همکاری در حال سیل است. اگر از شیرجه رفتن به هوش مصنوعی کاربردی هیجان زده اید ، یک شریک مطالعه می خواهید ، یا حتی می خواهید برای پروژه Passion خود شریک پیدا کنید ، به کانال همکاری بپیوندید! به این بخش نیز توجه داشته باشید – ما هر هفته فرصت های جالب را به اشتراک می گذاریم!

1 superuser666_sigil عضو RlagentBot ، یک نماینده تجارت رمزنگاری است. تیم آنها به دنبال افراد با اوقات فراغت برای کمک به دانش تجارت مالی/رمزنگاری خود به تیم ما است. اگر این دامنه شماست ، با او در موضوع ارتباط برقرار کنید!

2 cpnk75m در حال کار بر روی یک برنامه AR + AI برای Devpost Hackathon است و در انتخاب حق به کمک نیاز دارد مولکول مدل ها ، برخی از هک های سریع برای اجرای آن ، اشیاء AR/modals برای پوشش و آزمایش جامد. اگر علاقه مند به کار روی این پروژه هستید و به طور بالقوه آن را مقیاس می کنید ، به موضوع دسترسی پیدا کنید!

Meme of Week!

Meme به اشتراک گذاشته شده توسط bin4ry_d3struct0r

بخش سرپرستی تای

مقاله هفته

مقایسه چهار روش پیش بینی سری زمانی: پیامبر ، Deepar ، TFP-STS و ARATIVE AR از طرف شنگگانگ لی

انتخاب یک مدل پیش بینی سری زمانی مناسب یک چالش عملی است که شامل تجارت بین دقت و پیچیدگی است. این قطعه یک تجزیه و تحلیل مقایسه ای از چهار روش مجزا با استفاده از حمل و نقل ایالات متحده ارائه می دهد مجموعه دادهبشر این مدل مدل های استاندارد صنعت ، از جمله پیامبر متا ، Deepar آمازون و TFP-ST Google را در کنار یک مدل AR با دست و پا گیر تطبیقی پیشنهادی ارزیابی می کند. این یافته ها حاکی از آن است که در حالی که پیامبر در تفسیر و Deepar از الگوهای پیچیده به طور مؤثر برخورد می کند ، مدل تطبیقی نویسنده با اولویت بندی داده های اخیر به صورت رقابتی انجام می شود.

مقالات باید بخوانید

1 کاهش توهم در VLM با استفاده از معکوس از طرف یوسف فاراگ

برای پرداختن به توهم در مدل های زبان بینایی (VLM) ، محققان یک چارچوب برای تشخیص خطای در زمان واقعی و اصلاح خود را توسعه داده اند. این مدل بر روی یک سرپرست آموزش داده می شود مجموعه داده حاوی نمونه هایی از محتوای واقعی و توهم ، به آن آموزش می دهد تا نادرستی های احتمالی خود را بشناسد. در طول نسل ، اگر احتمال توهم بیش از یک آستانه تعیین شده باشد ، سیستم به طور خودکار از نمونه گیری رد یا بازنویسی پرس و جو برای تولید یک پاسخ پایه تر استفاده می کند. این رویکرد عملکرد بهبود یافته نسبت به روشهای موجود در زیرنویس و معیارهای پاسخ به سؤال را نشان داده است ، در حالی که تجارت بین دقت واقعی و بیان توصیفی را نیز برجسته می کند.

2 XAI: شبکه های عصبی نمودار از طرف کالپان دارامشی

این مقاله به تفسیر شبکه های عصبی نمودار (GNN) از طریق AI قابل توضیح (XAI) می پردازد. این تشریح می کند که چگونه GNN ها با جمع کردن داده ها از گره های همسایه برای انجام کارهایی مانند طبقه بندی گره عملکرد دارند. با استفاده از مجموعه داده های کاراته باشگاه زاخاری ، یک شبکه توجه نمودار برای پیش بینی عضویت در گروه آموزش داده می شود. سپس از ابزار GNNExPlainer برای تجزیه و تحلیل یک پیش بینی خاص استفاده می کند ، از لحاظ بصری تأثیرگذارترین گره های همسایه و ویژگی های ورودی را شناسایی می کند. این نشان می دهد که چگونه XAI بینش در مورد تصمیم گیری یک GNN را ارائه می دهد ، که برای اشکال زدایی ، اعتبار سنجی مدل و ایجاد اعتماد در نتایج ارزشمند است.

3 راهنمای بصری مبتدی برای روشهای کمیت برای LLMS از طرف پارت چاخرا

بهینه سازی مدلهای بزرگ زبان برای استقرار کارآمد یک ضرورت رو به رشد است. این وبلاگ یک راهنمای بصری برای کمیت ، فرایند کاهش دقت عددی برای ایجاد مدلهای کوچکتر و کارآمدتر ارائه می دهد. این دو رویکرد اصلی را تشریح می کند: آموزش کمیت-آگاه (QAT) ، که در مرحله آموزش یکپارچه شده است ، و کمیت پس از آموزش (PTQ) ، برای یک مدل تکمیل شده اعمال می شود. خلاصه بیشتر روشهای مختلف PTQ ، از جمله تکنیک های مبتنی بر کالیبراسیون (GPTQ ، AWQ) ، فقط وزن و پویا را نشان می دهد. سرانجام ، این قالب های ضروری استقرار ، مانند GGUF و ONNX را در بر می گیرد و نشان می دهد که چگونه استراتژی بهینه به تعادل دقت ، کارآیی و الزامات سخت افزاری بستگی دارد.

4 چت AI در دستگاه AI و ترجمه در Android (Qualcomm Genie ، MLC ، Webllm): تلفن شما ، LLM شما از طرف تارون سینگ

در این مقاله یک رویکرد عملی در مورد هوش مصنوعی در دستگاه Android ارائه شده است ، با تمرکز بر اجرای چارچوب MLC-LLM برای یک برنامه چت و ترجمه آفلاین. این یک ماژول کامل Kotlin را برای استفاده فوری از طریق مکانیسم برگشت پذیر فراهم می کند. این ماژول برای ارتقاء یکپارچه به استنتاج کامل MLC پس از افزودن کتابخانه های رسمی ، با استفاده از تأمل برای تشخیص زمان اجرا ، ساخته شده است. همچنین پیکربندی ماژول ، بسته بندی مدل و ملاحظات عملکرد را در تراشه های Snapdragon پوشش می دهد.

اگر علاقه مند به انتشار با AI هستید ، دستورالعمل های ما را بررسی کرده و ثبت نام کنیدبشر اگر این سیاست ها و استانداردهای تحریریه ما را رعایت کند ، کار شما را به شبکه خود منتشر خواهیم کرد.

منتشر شده از طریق به سمت هوش مصنوعی