عملیات هوش مصنوعی ایلان ماسک xAI هفته گذشته آخرین نسخه چت بات خود، Grok-2 را به صورت بتا برای کاربران ممتاز X (توئیتر سابق) منتشر کرد. مانند برخی از سیستم های رقیب، اکنون دارای قابلیت تولید تصویر مبتنی بر سریع است.

کاربران به سرعت تواناییهای آن را آزمایش کردند و به زودی متوجه شدند که فاقد نردههای محافظ محصولات رقیب است. آنها قادر به ایجاد دیپفیک از افراد واقعی، از جمله موسیقیدانان و سیاستمداران در موقعیتهای سازشآور بودند. یکی این ایده ها را ترکیب کرد و تصویری از ازدواج دونالد ترامپ با تیلور سویفت و دیگری سوئیفت با کلاه MAGA ایجاد کرد.

همچنین با حق چاپ سریع و آزاد پخش شد و تولید تصاویر خشونت آمیز و مستهجن را فعال کرد. میکی موس در حالی که سیگار می کشید و الکل می نوشید در حالی که یک ابر قارچ هسته ای پشت سرش منفجر شد و پیکاچو در حالی که یک AK-47 حمل می کرد به تصویر کشیده شد.

و در حالی که ماسک این انتشار را با تصاویری چاپلوس کننده از خود به عنوان یک گاوچران و ژست گرفتن با کت چرمی تبلیغ می کرد، برخی از کاربران آن را علیه او قرار دادند و او را به عنوان اضافه وزن یا در حال بوسیدن ترامپ نشان دادند.

در مقابل، ابزارهای رقیب مانند Gemini گوگل با به تصویر کشیدن چهره های سفیدپوست تاریخی مانند پدران بنیانگذار سربازان آلمانی دوران نازی به عنوان رنگین پوستان، تعصبات را بیش از حد جبران کردند.

در اینجا کارشناسان در مورد اینکه چه اشتباهی رخ داده است و اینکه آیا می توان به تعادل سالم در تولید تصویر هوش مصنوعی دست یافت، بررسی می کنند.

رایان ویت، معاون امور عمومی در Think Big

فقدان حفاظ های تعدیل محتوا در Grok مسائل اخلاقی و حقوقی قابل توجهی را نشان می دهد. کارشناسان حقوقی و مدافعان حقوق مدنی استدلال می کنند که Grok یکی از بی پرواترین پیاده سازی های هوش مصنوعی است. ایجاد بیهوده تصاویر بالقوه مضر، X را در برابر مسئولیتهای قانونی بزرگ باز میکند. چنین تصاویری به راحتی می توانند به عنوان اطلاعات نادرست، آزار جنسی یا نقض حق چاپ طبقه بندی شوند.

پرچمهای قرمز قانونی به تنهایی ارزیابی مجدد پروتکلهای تعدیل محتوای Grok را تضمین میکنند. چیزی که این موضوع را عجیبتر میکند، انتقاد شدید الون ماسک از هوش مصنوعی و مشکلاتی است که محصول هوش مصنوعی او در ایجاد آن مقصر است. می توان فکر کرد که ماسک در مورد هر چیزی که به هوش مصنوعی مربوط می شود بسیار محتاط است.

Grok قابل تعمیر است، اما احتمالاً نیاز به خاموش کردن آن برای ابزار جدید دارد. رفع نیاز به تنظیمات تکنولوژیکی و تغییر در فلسفه اساسی چگونگی توسعه و استقرار این ابزارها دارد.

اجرای فیلترهای محتوای بهتر، بهبود سیاست های تعدیل و اطمینان از شفافیت در نحوه آموزش و استفاده از هوش مصنوعی می تواند برخی از خطرات Grok را کاهش دهد. با این حال، این احتمالاً یک فرآیند پیچیده و مداوم خواهد بود که شامل همکاری بین فنآوران، اخلاقشناسان و سیاستگذاران است.

جی دی هریمن، شریک در گروه حقوقی بنیاد

Grok و Gemini دو تولید کننده تصویر هوش مصنوعی هستند که تصاویر بحث برانگیزی تولید می کنند اما به دلایل اشتباه. از هر دو ژنراتور می توان برای ایجاد تصاویر نادرست و گمراه کننده استفاده کرد، Gemini به دلیل فیلتر زیاد و Grok به دلیل فیلتر بسیار کم.

Gemini این خبر را در ابتدای سال 2024 به دلیل تولید تصاویر غیرمحتمل تاریخی، اگر نگوییم کاملاً نادرست، به دلیل فیلتر بیش از حد اصلاحی که برای جلوگیری از مشکلات تعصب نژادی شناخته شده با هوش مصنوعی طراحی شده بود، منتشر کرد. در مقابل، کاربران Grok تقریباً هیچ فیلتری غیر از پورن سخت هستهای را در Grok Generator شناسایی نکردهاند. در نتیجه، کاربران Grok تصاویری آشکار از سیاستمداران و شخصیتهای عمومی که درگیر رفتار توهینآمیز هستند، ساختهاند.

بهترین مکان برای خط کشی برای تولیدکنندگان تصویر هوش مصنوعی کجاست؟ خواه خود ژنراتور فیلتر داشته باشد، تصاویر تولید شده در حال حاضر تحت نظارت قانونی قرار دارند. نقض حق نسخهبرداری، نقض علامت تجاری، افترا، تحریک و سایر راهحلهای حقوقی کاملاً در دسترس است تا بر روی تصاویر تولید شده توسط مولد Grok اعمال شود. ممکن است اجرای سیاست حذف برای Grok، مشابه YouTube، دشوار باشد، زیرا Grok فقط تصاویر را ایجاد می کند و آنها در جای دیگری پست می شوند.

اجرا و اجرای گاردریل های اخلاقی دشوارتر است. یکی از تکنیکهایی که OpenAI استفاده میکند، واترمارک روی تمام تصاویر تولید شده است. این واترمارک حداقل میتواند به بینندگان این امکان را بدهد که بدانند آیا یک تصویر تولید شده توسط هوش مصنوعی را میبینند یا خیر و شک و تردید خود را به رخ میکشد. خوب است که یک واترمارک مخفی داشته باشید که به سختی حذف شود تا امکان بررسی مناسب تصاویر برای کاهش خطر آسیب وجود داشته باشد.

مت حسن، بنیانگذار و مدیر عامل شرکت airresults

Grok، سیستم هوش مصنوعی پیشرفته xAI، با مناقشات قابل توجهی مواجه شده است، به ویژه در مورد دستکاری و تولید تصاویر. به عنوان مثال، مواردی وجود داشته است که از Grok برای ایجاد تصاویر فوق واقعی اما کاملاً ساختگی استفاده شده است که منجر به انتشار اطلاعات نادرست و افترا می شود. چنین سوء استفادهای، فقدان حفاظ اخلاقی و قانونی سیستم را برجسته میکند، و نگرانیهایی را در مورد احتمال سوءاستفاده در ایجاد رسانههای گمراهکننده یا نقض مالکیت معنوی ایجاد میکند.

فقدان مکانیسمهای نظارتی قوی به این معنی است که محتوای مضر یا غیراخلاقی میتواند بدون کنترل تکثیر شود. برای کاهش این مشکلات، اجرای سیاستهای تعدیل محتوا، توسعه ابزارهای تشخیص پیشرفته برای شناسایی تصاویر دستکاری شده و ایجاد چارچوبهای قانونی واضح برای محتوای تولید شده توسط هوش مصنوعی، گامهای حیاتی هستند. همچنین، تقویت شفافیت در توسعه هوش مصنوعی و تشویق استانداردهای کل صنعت میتواند به اطمینان از استفاده مسئولانه و اخلاقی از چنین فناوریهایی کمک کند.

شاشی بلامکوندا، مدیر تحقیقات اصلی در گروه تحقیقاتی اطلاعات فناوری

ارائه دهندگان مدل زبان بزرگ هوش مصنوعی (LLM) با یک معضل روبرو هستند. اگر محدود کننده باشند، کاربران آنها را هیجانانگیز نمیدانند و اگر محدود نیستند، با جنجال و خشم مواجه میشوند. گروک میخواهد با فلسفه آزادی بیان و افزایش نوآوری ایلان ماسک محدود نباشد. تولید تقلبی نه نوآورانه است و نه قانونی. مگر اینکه این شرکتها جنبههای خلاقانهشان را خود پلیسی کنند، اعتماد به هوش مصنوعی به ضرر شرکتهای هوش مصنوعی که با هوش مصنوعی تحلیلی و پیشبینیکننده کار خوبی انجام میدهند، کاهش مییابد.

از آزمایشات من، تصاویر ایجاد شده توسط Grok نماینده هستند اما همیشه دقیق نیستند و یک کاربر باهوش می تواند آنها را جعلی تشخیص دهد. کامالا هریس درست کردن دوسا نمونه ای از آن است.

تصویری که توسط گروک از کامالا هریس در حال ساخت یک دوسا ساخته شده است. گروه تحقیقاتی اطلاعات فناوری اعتباری از طریق Grok

راب روزنبرگ، وکیل در سطح اجرایی و استراتژیست دیجیتال برای رسانه ها، استریمینگ، پلتفرم های توسعه، قانون مالکیت معنوی و هوش مصنوعی

گروک تلاش میکند تا خود را از سایر مدلهای هوش مصنوعی متمایز کند و خود را اعلام کند که «یک دستیار جستجوی هوش مصنوعی با طنز و طنز و شورش». میخواهد به شما در پرسشهای جستجویتان کمک کند و در عین حال شما را «سرگرم و درگیر» نگه دارد. اهداف بزرگ، تا زمانی که محتوای تولید شده توسط مدل کاربران را تحقیر، کلاهبرداری یا اطلاعات نادرست نکند.

برخلاف سایر پلتفرمها که تصاویر تولید شده توسط هوش مصنوعی خود را با واترمارکی که آنها را مشخص میکند برچسبگذاری میکنند، Grok نتایج تصویر خود را بهگونهای برچسبگذاری نمیکند که در مشتریان پاییندستی به منشأ آنها اشاره کند. این چنین مشتریان پایین دستی را در معرض خطر گمراه شدن قرار می دهد – این گونه تصاویر را به عنوان واقعی و نه عمیق تعبیر می کنند. کسانی که در Grok تصاویر ایجاد می کنند ممکن است بدانند که قصد دارند طنز باشند، اما وقتی این تصاویر به طور گسترده به اشتراک گذاشته می شوند، مصرف کنندگان ناآگاه ممکن است متوجه نشوند که آنها توسط هوش مصنوعی تولید شده اند.

حرکتی به سمت حفاظت بیشتر برای مصرف کنندگان به جای کمتر وجود دارد. قانون بدون جعل، یک قانون دو حزبی که حمایت گسترده ای از سوی استعدادها، صنعت و گروه های مصرف کننده به دست می آورد، با هدف محافظت از مردم در برابر ایجاد و به اشتراک گذاری تصاویر عمیق جعلی است. حامیان این لایحه امیدوارند تا قبل از پایان سال 2024 شاهد تبدیل آن به قانون باشند. با فرض اینکه قانون ممنوعیت تقلبی به قانون تبدیل شود، تصور میکنم که گروک مجبور خواهد شد دستورالعملهای مسئولانهای را مطابق با این قانون جدید وضع کند.

ادوارد تیان، مدیر عامل شرکت GPTZero

Grok ثابت کرده است که می تواند تصاویر اخلاقی مشکوک و نامناسب ایجاد کند. شخصیتهای عمومی در صحنههای خشونت و تحقیر به تصویر کشیده شدهاند، بدون اینکه اجازه استفاده از شباهتهایشان را به این شکل بدهند. و از آنجایی که سواد رسانه ای به طور گسترده وجود ندارد، مطمئناً افراد زیادی هستند که این تصاویر را خواهند دید و فوراً واقعی بودن آنها را باور خواهند کرد. بنابراین، اگر به زودی اقدامات قانونی انجام شود، تعجب نخواهم کرد.

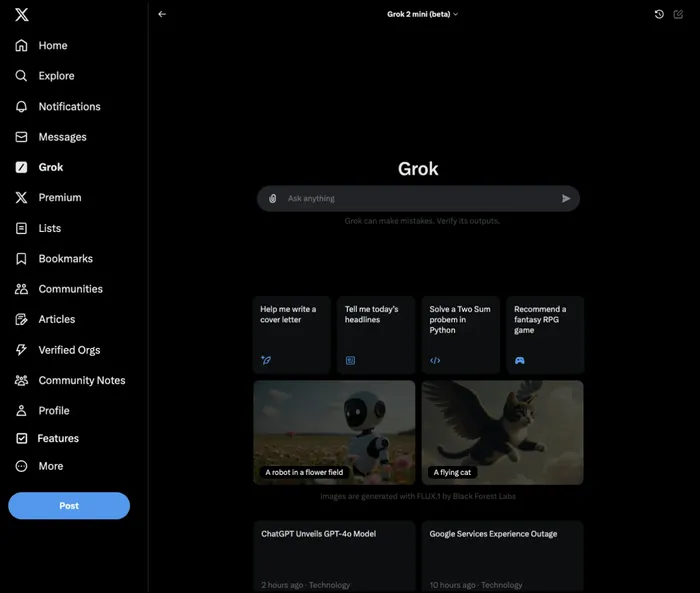

صفحه نمایش سریع Grok. اعتبار: Grok

مارک مکناسبی، یکی از بنیانگذاران و مدیرعامل Ivy.ai

در رقابت برای نوآوری، حتی امیدوارکنندهترین فناوریها نیز میتوانند در صورت بکارگیری زودهنگام دچار تزلزل شوند. مناقشات اخیر پیرامون هوش مصنوعی Grok Elon Musk بر یک مسئله حیاتی تأکید می کند – خطر تکیه بر مدل های هوش مصنوعی نابالغ برای اطلاعات پرمخاطره. اعتراف صریح ماسک به دوران نوزادی گروک، در کنار جاهطلبی او برای اینکه هوش مصنوعی مظهر حقیقت باشد، دوگانگی مهم در توسعه هوش مصنوعی را برجسته میکند.

با نگاهی به آینده، با تکامل چشم انداز دیجیتال، نیاز به سیستم های قوی برای تأیید و تأیید اطلاعات بیش از پیش ضروری می شود. حوادث گروک پیچیدگی تنظیم دقیق مدلهای مقیاس بزرگ و اهمیت فوقالعاده دقت در خروجیهای هوش مصنوعی را نشان میدهد. با چشم انداز فناوری به پویایی همیشه، آنچه امروز وجود دارد ممکن است فردا تغییر کند. این سیال بودن مدلهای هوش مصنوعی را ایجاب میکند که نه تنها پیشرفته باشند، بلکه برای صحت واقعی نیز به دقت تأیید شده باشند.

مارک بیدلز، مدیر عامل و یکی از بنیانگذاران rTriibe

توانایی Grok برای تولید تصاویر بحث برانگیز و از نظر قانونی مشکوک، شکاف هشدار دهنده در مقررات هوش مصنوعی را برجسته می کند.

بدون چارچوب یا دستورالعملهای روشن، این ابزارهای قدرتمند در معرض سوء تعبیر و سوء استفاده قرار میگیرند و منظرهای را ایجاد میکنند که در آن نوآوری میتواند به راحتی به تخلف تبدیل شود.

فقدان نظارت نه تنها باعث ایجاد بازی ناپسند میشود، بلکه بر نیاز فوری به قوانین جامع برای هدایت میدانهای مین اخلاقی و قانونی خلاقیت مبتنی بر هوش مصنوعی تأکید میکند.”

ریک بنتلی، بنیانگذار و آبهیک سرکار، مدیر یادگیری ماشین در کلوداستراچرچر

شباهت های تاریخی بین رویکرد امپراتوری عثمانی به چاپخانه و سیستم هوش مصنوعی بسته مدرن وجود دارد. در قرن پانزدهم، امپراتوری عثمانی که نسبت به پتانسیل چاپخانه برای گسترش مخالفت و به چالش کشیدن قدرت محتاط بود، استفاده از آن را به شدت محدود کرد. این تصمیم، در حالی که برای حفظ ثبات اجتماعی در نظر گرفته شده بود، در نهایت مانع از پیشرفت فکری و فناوری در داخل امپراتوری شد.

امروز، ما شاهد پویایی مشابهی در حوزه هوش مصنوعی هستیم. سیستمهای هوش مصنوعی بسته که به شدت توسط شرکتها یا دولتها کنترل میشوند، بازتاب رویکرد عثمانی هستند. این نهادها اغلب سیاست های محدودکننده خود را با ذکر نگرانی در مورد سوء استفاده احتمالی، خطرات امنیتی یا نیاز به حفظ مزیت های رقابتی توجیه می کنند. با این حال، این رویکرد سوالات مهمی را در مورد نوآوری، پیشرفت اجتماعی و توزیع عادلانه مزایای تکنولوژیکی مطرح می کند.

همانطور که دسترسی به فناوری چاپ منجر به چاپ غیرقانونی پول توسط همه نمی شود، دسترسی به فناوری هوش مصنوعی نیز ذاتاً منجر به نتایج منفی نمی شود. به جای تمرکز صرف بر مقررات برای جلوگیری از سوء استفاده احتمالی از هوش مصنوعی، یک استدلال قوی برای اولویت دادن به نوآوری، به ویژه در حوزه فناوری های تشخیص و تأیید وجود دارد، به طوری که تنها تعداد انگشت شماری از افراد از آن سوء استفاده نکنند.

بحث این نیست که آیا قابل تعمیر است یا خیر، بلکه باید «تعمیر» شود؟ اکثر قانونگذاران در مورد فناوری های پیشرفته ای مانند هوش مصنوعی هیچ چیز هوشمندانه ای برای گفتن ندارند. ما یک جامعه سرمایه داری هستیم و نیروهای بازار ما را فراتر از درک تاریخی بشر ثروتمند ساخته اند. بدترین کاری که میتوانیم برای یک فناوری نوپا انجام دهیم این است که اجازه دهیم ترسآفرینی ما را از آزادیهایمان سلب کند و سپس ما را از تمام مزایای اجتماعی که از انقلاب فناوری بعدی به دست میآوریم محروم کند – یا بدتر از همه، آن را فقط برای شرکتهای بزرگ در دسترس قرار دهیم. که می توانند از عهده مقررات برآیند.

در Cloudastructure، ما در حال حاضر از Grok برای ایجاد تصاویر مصنوعی برای کمک به آموزش سیستم خود برای شناسایی اسلحه در فیدهای نظارت تصویری استفاده می کنیم. تشخیص اسلحه به وضوح یک مسئله ایمنی عمومی است و ما مفتخریم که در این فناوری پیشگام هستیم. با این حال، برای مثال، یافتن ویدیویی از اسلحههایی که در مراکز خرید استفاده میشوند، سخت است، و در جایی که چنین فیلمهایی وجود دارد، به حق، تردیدهای اخلاقی در مورد استفاده از آن دادهها برای آموزش وجود دارد – فیلم واقعی از تیراندازیهای واقعی با قربانیان واقعی. داشتن سیستم هایی مانند Grok و اجازه دادن به آنها برای رشد بدون تداخل به محافظت از عموم کمک می کند.

همانطور که پدرم می گوید، اگر خراب نیست، آن را تعمیر نکنید.

منبع: https://aibusiness.com/chatbot/grok-2-generates-controversy-expert-reactions