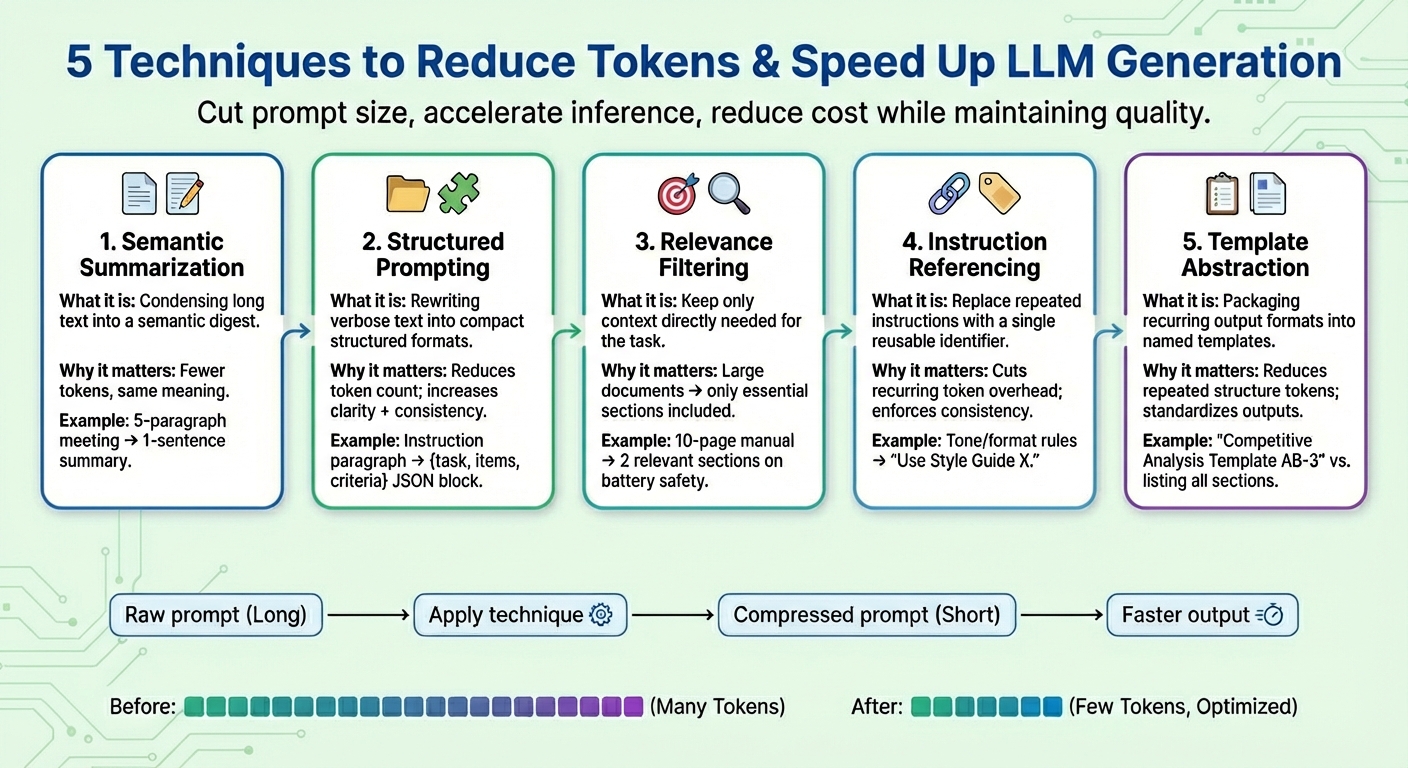

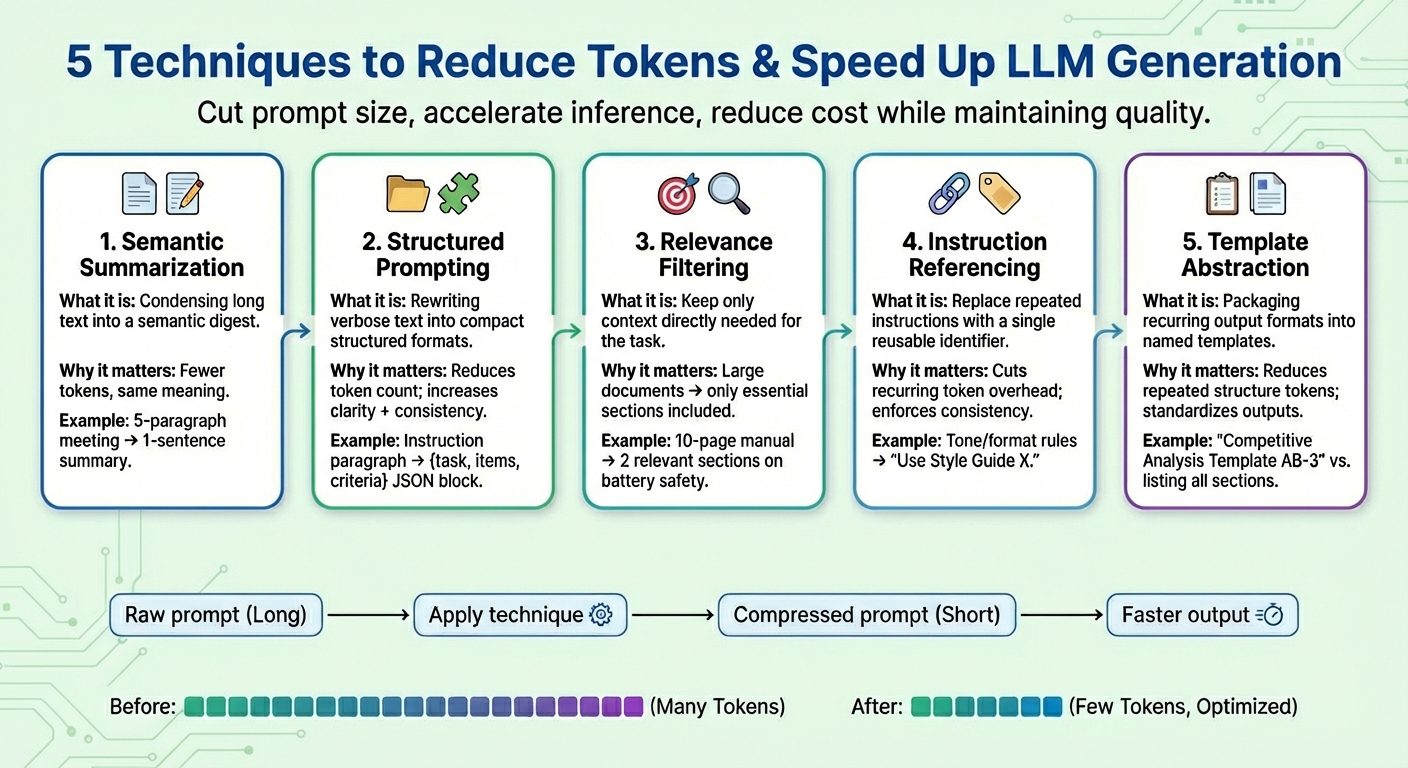

در این مقاله، پنج تکنیک فشرده سازی سریع عملی را یاد خواهید گرفت که توکن ها را کاهش می دهد و تولید مدل زبان بزرگ (LLM) را بدون کاهش کیفیت کار سرعت می بخشد.

موضوعاتی که به آنها خواهیم پرداخت عبارتند از:

- خلاصه معنایی چیست و چه زمانی باید از آن استفاده کرد

- اعلان ساختاری، فیلتر ارتباط، و ارجاع دستورالعمل برش توکن شمارش می شود

- انتزاع الگو در کجا قرار می گیرد و چگونه می توان آن را به طور مداوم اعمال کرد

بیایید این تکنیک ها را بررسی کنیم.

فشرده سازی سریع برای بهینه سازی نسل LLM و کاهش هزینه

تصویر توسط ویرایشگر

مقدمه

مدل های زبان بزرگ (LLMs) عمدتاً برای ایجاد پاسخهای متنی به سؤالات یا درخواستهای کاربر، با استدلال پیچیده زیر سرپوشیده آموزش دیدهاند که نه تنها شامل تولید زبان با پیشبینی هر نشانه بعدی در دنباله خروجی است، بلکه مستلزم درک عمیق الگوهای زبانی پیرامون متن ورودی کاربر است.

فشرده سازی سریع تکنیکها یک موضوع تحقیقاتی هستند که اخیراً به دلیل نیاز به کاهش استنتاج آهسته و زمانبر ناشی از درخواستهای کاربر بزرگتر و پنجرههای زمینه، توجه را در سراسر چشمانداز LLM به خود جلب کرده است. این تکنیکها برای کمک به کاهش استفاده از توکن، تسریع تولید توکن و کاهش هزینههای محاسباتی کلی طراحی شدهاند و در عین حال کیفیت نتیجه کار را تا حد امکان حفظ میکنند.

این مقاله پنج تکنیک فشرده سازی سریع را که معمولاً مورد استفاده قرار می گیرد برای سرعت بخشیدن به تولید LLM در سناریوهای چالش برانگیز ارائه و توصیف می کند.

1. خلاصه معنایی

خلاصهسازی معنایی تکنیکی است که محتوای طولانی یا تکراری را در نسخهای مختصرتر فشرده میکند و در عین حال معنای اساسی خود را حفظ میکند. به جای تغذیه کل مکالمه یا اسناد متنی به مدل به صورت مکرر، خلاصه ای که فقط شامل موارد ضروری است ارسال می شود. نتیجه: تعداد نشانههای ورودی که مدل باید بخواند کمتر میشود، در نتیجه فرآیند تولید توکن بعدی تسریع میشود و هزینهها بدون از دست دادن اطلاعات کلیدی کاهش مییابد.

فرض کنید یک متن سریع طولانی شامل صورتجلسه جلسه، مانند «در جلسه دیروز، ایوان اعداد سه ماهه را بررسی کرد…“، جمع بندی حداکثر پنج پاراگراف. پس از خلاصه معنایی، متن کوتاه شده ممکن است شبیه به “خلاصه: ایوان اعداد سه ماهه را بررسی کرد، کاهش فروش در سه ماهه چهارم را برجسته کرد و اقداماتی را برای صرفه جویی در هزینه پیشنهاد کرد.”

2. اعلان ساختار یافته (JSON).

این تکنیک بر بیان قطعات طولانی و روان اطلاعات متنی در قالبهای فشرده و نیمه ساختار یافته مانند JSON (یعنی جفتهای کلید-مقدار) یا لیستی از نقاط گلوله تمرکز دارد. قالبهای هدف مورد استفاده برای تحریک ساختاریافته معمولاً کاهش تعداد توکنها را به دنبال دارد. این به مدل کمک می کند تا دستورالعمل های کاربر را با اطمینان بیشتری تفسیر کند و در نتیجه، سازگاری مدل را افزایش می دهد و ابهام را کاهش می دهد و در عین حال اعلان ها را در طول مسیر کاهش می دهد.

الگوریتمهای اعلان ساختیافته ممکن است اعلانهای خام را با دستورالعملهایی مانند تغییر شکل دهند لطفاً مقایسه دقیقی بین محصول X و محصول Y با تمرکز بر قیمت، ویژگیهای محصول و رتبهبندی مشتریان ارائه دهید به شکل ساختاری مانند: {وظیفه: «مقایسه»، موارد: [“Product X”, “Product Y”]، معیارها: [“price”, “features”, “ratings”]}

3. Relevance Filtering

فیلتر ارتباط، اصل «تمرکز بر آنچه واقعاً مهم است» را اعمال میکند: ارتباط را در بخشهایی از متن اندازهگیری میکند و در آخرین درخواست تنها بخشهایی از زمینه را که واقعاً برای کار مورد نظر مرتبط هستند، ترکیب میکند. به جای ریختن کل اطلاعات مانند اسنادی که بخشی از زمینه هستند، فقط زیرمجموعه های کوچکی از اطلاعاتی که بیشترین ارتباط را با درخواست هدف دارند نگهداری می شوند. این روش دیگری برای کاهش شدید اندازه سریع است و به مدل کمک می کند تا از نظر تمرکز و دقت پیش بینی بهتر رفتار کند (به یاد داشته باشید که تولید توکن LLM در اصل یک کار پیش بینی کلمه بعدی است که بارها تکرار می شود).

به عنوان مثال، یک کتابچه راهنمای محصول 10 صفحهای کامل برای تلفن همراه را در نظر بگیرید که به عنوان پیوست اضافه شده است (زمینه فوری). پس از اعمال فیلتر مربوطه، تنها چند بخش کوتاه مرتبط در مورد «عمر باتری» و «فرایند شارژ» حفظ میشوند زیرا از کاربر در مورد پیامدهای ایمنی هنگام شارژ کردن دستگاه خواسته شده است.

4. ارجاع دستورالعمل

بسیاری از اعلانها همان نوع دستورالعملها را بارها و بارها تکرار میکنند، بهعنوان مثال، «این لحن را اتخاذ کنید»، «در این قالب پاسخ دهید» یا «از جملات مختصر استفاده کنید». ارجاع دستورالعمل برای هر دستورالعمل رایج (شامل مجموعه ای از نشانه ها) یک مرجع ایجاد می کند، هر یک را فقط یک بار ثبت می کند و دوباره از آن به عنوان یک شناسه نشانه استفاده می کند. هر زمان که درخواست های آینده یک “درخواست مشترک” ثبت شده را ذکر کنند، از آن شناسه استفاده می شود. علاوه بر کوتاه کردن اعلانها، این استراتژی همچنین به حفظ رفتار ثابت در طول زمان کمک میکند.

مجموعه ای ترکیبی از دستورالعمل ها مانند “با لحن دوستانه بنویسید. از اصطلاحات خاص خودداری کنید. جملات را مختصر نگه دارید. مثال هایی ارائه دهید.” می تواند به عنوان “Use Style Guide X” ساده شود. و پس از مشخص شدن مجدد دستورالعمل های معادل، دوباره مورد استفاده قرار گیرد.

5. انتزاع الگو

برخی از الگوها یا دستورالعملها اغلب در میان اعلانها ظاهر میشوند – به عنوان مثال، ساختارهای گزارش، قالبهای ارزیابی، یا روشهای گام به گام. انتزاع الگو یک اصل مشابه را برای ارجاع دستورالعمل اعمال میکند، اما بر روی شکل و قالبی که خروجیهای تولید شده باید داشته باشند، تمرکز میکند و آن الگوهای رایج را تحت یک نام الگو قرار میدهد. سپس از ارجاع الگو استفاده می شود و LLM کار پر کردن بقیه اطلاعات را انجام می دهد. این نه تنها به شفافتر ماندن درخواستها کمک میکند، بلکه حضور توکنهای مکرر را نیز بهطور چشمگیری کاهش میدهد.

پس از انتزاع الگو، یک درخواست ممکن است به چیزی مانند «تولید یک تحلیل رقابتی با استفاده از الگوی AB-3» تبدیل شود. که در آن AB-3 لیستی از بخش های محتوای درخواستی برای تجزیه و تحلیل است که هر یک به وضوح تعریف شده است. چیزی شبیه به:

یک تحلیل رقابتی با چهار بخش تولید کنید:

- بررسی اجمالی بازار (2 تا 3 پاراگراف که روندهای صنعت را خلاصه می کند)

- تفکیک رقبا (جدول مقایسه حداقل 5 رقیب)

- نقاط قوت و ضعف (نقاط گلوله)

- توصیه های استراتژیک (3 گام قابل اجرا).

بسته بندی

این مقاله پنج روش متداول را برای سرعت بخشیدن به تولید LLM در سناریوهای چالش برانگیز با فشرده سازی اعلان های کاربر، که اغلب بر روی بخش متن آن متمرکز می شود، ارائه و شرح می دهد، که اغلب علت اصلی “اعلان های بیش از حد” است که باعث کاهش سرعت LLM می شود.