نویسنده (ها): یووال مهتا

در ابتدا منتشر شده در به سمت هوش مصنوعیبشر

تنظیم دقیق مدل های بزرگ زبان (LLMS) در سالهای اخیر به یک مؤلفه اساسی توسعه AI تبدیل شده و از یک تلاش فنی تخصصی حرکت می کند. تقویت عملکرد مدل دیگر تنها هدف نیست. کارآیی ، دسترسی ، تراز و ایمنی هم اکنون نیز ملاحظات مهمی هستند.

1. تنظیم کامل: مسیر کلاسیک

در طول دوره GPT-2 ، تنظیم دقیق کامل استاندارد بود. کل مدل توسط توسعه دهندگان با استفاده از a دوباره آموزش داده شد مجموعه داده منحصر به فرد برای دامنه. حتی اگر این روش هنوز هم بیشترین سطح کنترل و تخصص را ارائه دهد ، به ویژه برای فعالیت هایی مانند تصویربرداری پزشکی یا تجزیه اسناد قانونی ، بسیار گران است:

جوانب مثبت:

- کنترل کامل بر رفتار مدل

- عملکرد بالا در کارهای خاص دامنه

منفی ها:

- تقاضای محاسباتی بالا و حافظه

- به بزرگ نیاز دارد مجموعه داده ها

- وقت گیر

2. تنظیم دقیق پارامتر (PEFT): قدرت بدون برچسب قیمت

سازگاری با درجه پایین (لورا)

لورا با معرفی ماتریس های کم درجه قابل آموزش به لایه های از قبل موجود ، از ضرورت به روزرسانی هر پارامتر جلوگیری می کند. این عملکرد را حفظ می کند در حالی که نیاز به آموزش را به میزان قابل توجهی کاهش می دهد.

LORA کمکی (Qlora)

معرفی شده در سال 2023 ، QLORA با ترکیب تکنیک های کمیت با LORA ، مصرف حافظه را به میزان قابل توجهی کاهش می دهد و تنظیم دقیق مدل های میلیارد پارامتر در GPU های مصرف کننده را امکان پذیر می کند.

“Qlora با کاهش سد سخت افزاری ، تنظیم دقیق LLM را دموکراتیک می کند.”

لایه های آداپتور

در تنظیم دقیق مبتنی بر آداپتور ، لایه های پلاگین ریز در حالی که مدل اصلی یخ زده است آموزش داده می شوند. این مدولار آن را برای:

- کار آسان سوئیچینگ

- استقرار ساده

- کاهش هزینه محاسبات

جوانب مثبت:

- حداقل سربار محاسباتی

- ماژولار و قابل استفاده مجدد

- ایده آل برای تنظیمات با منابع محدود

منفی ها:

- ممکن است با عملکرد کامل تنظیم دقیق مطابقت نداشته باشد

- نیاز به ادغام خاص معماری دارد

3. تنظیم دستورالعمل: آموزش LLMS برای دنبال کردن سفارشات

تنظیم دستورالعمل مدل های مختلفی را ارائه می دهد که به جای آموزش آن بر روی یک مورد ، با دستورالعمل ها برچسب گذاری می شوند کاربشر این روش توانایی و تعمیم صفر را بهبود می بخشد.

پروژه های قابل توجه

- T0 (سان و همکاران)

- فلان (تحقیقات Google)

جوانب مثبت:

- تعمیم بهتر

- بهبود عملکرد صفر

منفی ها:

- به مجموعه داده های آموزش متنوع نیاز دارد

- به طور پیش فرض تراز خروجی را اجرا نمی کند

4. RLHF: تراز مدل ها با ارزش های انسانی

یکی از مؤلفه های اصلی مدل های تراز شده مانند ChatGPT یادگیری تقویت از بازخورد انسانی (RLHF) است. در سه مرحله عمل می کند:

- مقایسه های دارای برچسب انسانی را جمع آوری کنید

- یک مدل پاداش را آموزش دهید

- LLM را از طریق یادگیری تقویت کننده بهینه کنید

جوانب مثبت:

- تراز بهتر با ترجیحات انسانی

- پاسخهای مفید و ایمن تری ایجاد می کند

منفی ها:

- جمع آوری داده ها گران و کند است

- مقیاس و تکرار سخت است

5. تنظیم دقیق سیستم 2: به سمت استدلال بازتابنده

تنظیم دقیق System-2 ، که الهام بخش از علم شناختی است ، مدل ها را قادر می سازد تا به صورت سیستماتیک و هدفمند استدلال کنند. برجسته است:

- فکر ساختاری

- برنامه ریزی و تأمل

- استدلال چند هاپ یکپارچه

اگرچه هنوز در حال ظهور است ، کار توسط پارک و همکاران. (2025) نشان دهنده برنامه های امیدوارکننده در استدلال حقوقی و تحقیقات علمی است.

جوانب مثبت:

- استدلال و برنامه ریزی بهبود یافته

- استحکام و تفسیر پیشرفته

منفی ها:

- هنوز در دست توسعه است

- نیاز به نظارت دقیق دارد

6. تنظیم سریع و ارسال نرم: فرمان سبک وزن

ترفند سریع جایگزین سبک وزن برای زمینه هایی با محدودیت ها یا دسترسی محدود به API ها را فراهم می کند. به جای تغییر مدل ، بهترین درخواست ها را برای هدایت رفتار می آموزد.

به طور خاص ، فوری نرم ظریف و قدرتمند است زیرا در سطح تعبیه کار می کند.

جوانب مثبت:

- سریع و کم هزینه

- نیازی به دسترسی به داخلی مدل ندارد

منفی ها:

- کنترل محدود بر رفتار مدل عمیق

- برای کارهای استدلال پیچیده کمتر موثر است

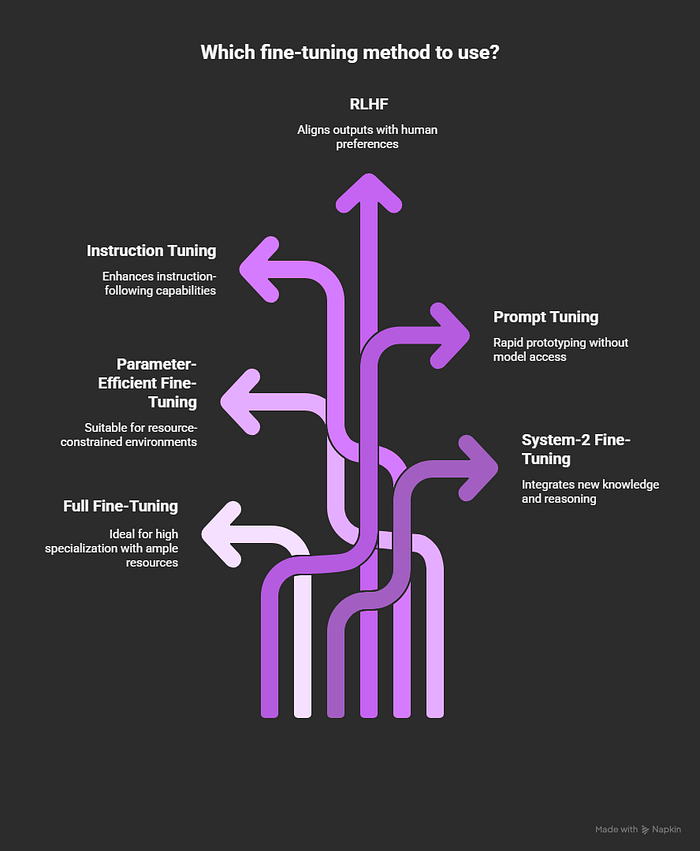

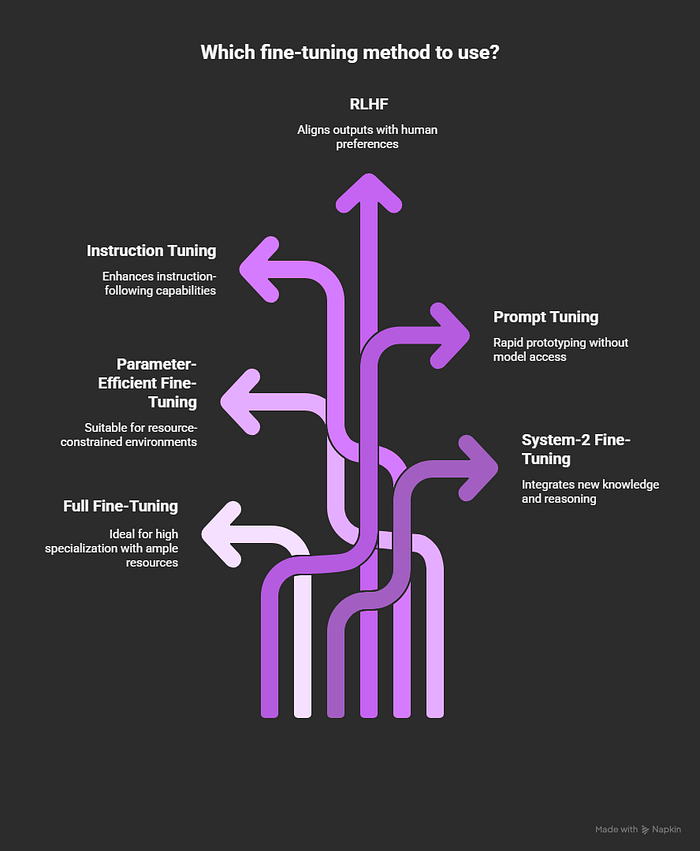

در یک نگاه: چه موقع از چه چیزی استفاده کنید

- تخصص بالا با منابع فراوان → استفاده کنید تنظیم کامل

- محیط های محدود شده از منابع → انتخاب کنید تنظیم دقیق پارامتر (مانند لورا یا قلرا)

- تقویت قابلیت های پیروی از دستورالعمل → با تنظیم دستورالعمل

- تراز کردن خروجی ها با ترجیحات انسانی … انتخاب کنید یادگیری تقویت از بازخورد انسانی (RLHF)

- نمونه سازی سریع بدون دسترسی به مدل → استفاده کنید تنظیم سریع

- ادغام دانش و استدلال جدید → درخواست کنید تنظیم دقیق سیستم

تصویر بزرگ: تنظیم دقیق به عنوان یک کاردستی

در سال 2025 ، تنظیم دقیق در مورد دانستن ابزارهای شما و زمان استفاده از آنها است ، نه فقط در مورد انتخاب یک رویکرد. برای استحکام اضافه شده ، ممکن است مقداری RLHF اضافه کرده و لورا را با تغییر دستورالعمل ترکیب کنید.

این همزمان یک انتخاب استراتژیک ، یک تجارت عملکرد و یک انتخاب طراحی است.

“تنظیم دقیق امروز کمتر در مورد کد و بیشتر در مورد کاردستی است.”

منابع

- هو و همکاران ، 2021 – لورا: سازگاری با درجه پایین از مدل های بزرگ زبان

- Dettmers و همکاران ، 2023 – Qlora: کارآمد LLMS کمکی

- پفیفر و همکاران ، 2020 – AdapterFusion: ترکیب کار غیر مخرب برای یادگیری انتقال

- سان و همکاران ، 2021 – چند وظیفه ای آموزش مدل های زبان (T0)

- اویانگ و همکاران ، 2022 – مدلهای زبان آموزشی برای دنبال کردن دستورالعمل با بازخورد انسان

- لستر و همکاران ، 2021 – قدرت مقیاس برای تنظیم سریع پارامتر

- پارک و همکاران ، 2025 – تنظیم دقیق System-2 برای ادغام قوی دانش جدید

منتشر شده از طریق به سمت هوش مصنوعی