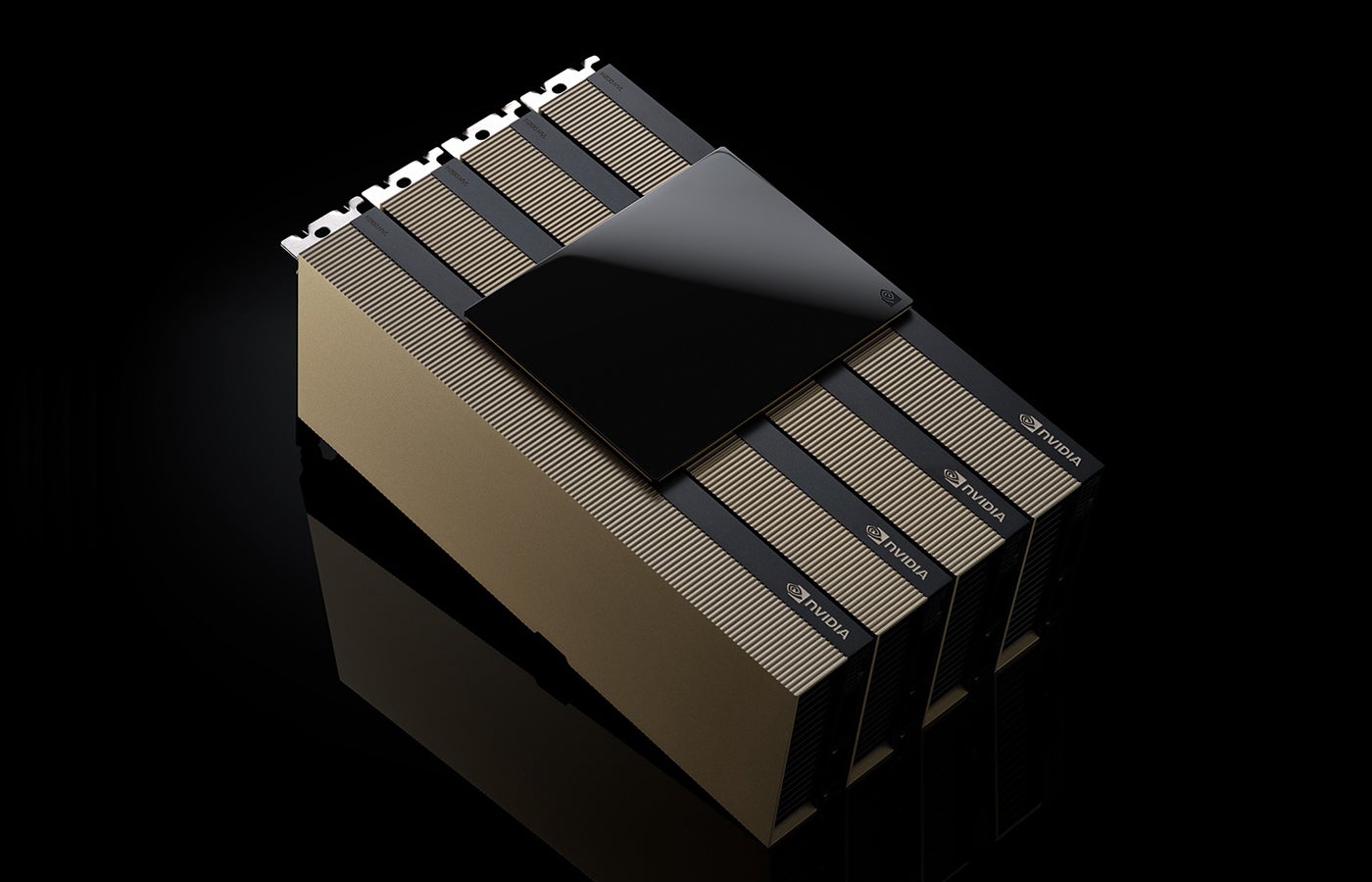

NVIDIA زیرساختها، سختافزار و منابع مختلفی را برای تحقیقات علمی و سازمانی در کنفرانس بینالمللی محاسبات، شبکه، ذخیرهسازی و تجزیه و تحلیل با عملکرد بالا که از 17 تا 22 نوامبر در آتلانتا برگزار شد، نشان داد. کلیدی در میان این اعلامیه ها در دسترس بودن عمومی آینده شتاب دهنده هوش مصنوعی H200 NVL بود.

جدیدترین تراشه هاپر در ماه دسامبر عرضه می شود

NVIDIA در یک نشست رسانه ای در 14 نوامبر اعلام کرد که پلتفرم های ساخته شده با H200 NVL PCIe GPU در دسامبر 2024 در دسترس خواهند بود. مشتریان سازمانی می توانند برای H200 NVL به یک معماری مرجع سازمانی مراجعه کنند. خرید GPU جدید در مقیاس سازمانی با یک اشتراک پنج ساله برای سرویس NVIDIA AI Enterprise همراه است.

دیون هریس، مدیر محاسبات شتابدهنده NVIDIA، در جلسه توجیهی گفت که H200 NVL برای مراکز داده با توان کمتر – کمتر از 20 کیلووات – و طراحی قفسههای شتابدهنده هوا خنک ایدهآل است.

هریس گفت: “شرکت ها می توانند LLM ها را در عرض چند ساعت با GPU آینده تنظیم کنند.”

H200 NVL نسبت به NVIDIA H100 NVL 1.5 برابر افزایش حافظه و 1.2 برابر افزایش پهنای باند را نشان می دهد.

Dell Technologies، Hewlett Packard Enterprise، Lenovo و Supermicro از GPU جدید PCIe پشتیبانی خواهند کرد. همچنین در پلتفرم هایی از Aivres، ASRock Rack، گیگابایت، Inventec، MSI، Pegatron، QCT، Wistron و Wiwynn ظاهر خواهد شد.

ببینید: شرکت هایی مانند اپل سخت کار می کنند تا یک نیروی کار سازندگان تراشه.

ادامه عرضه تراشه گریس بلکول

هریس همچنین تاکید کرد که شرکا و فروشندگان تراشه NV GB200 NVL4 (Grace Blackwell) را در دست دارند.

او گفت: «عرضه Blackwell به آرامی در حال انجام است.

چیپس بلک ول هستند فروخته شد تا سال آینده

رونمایی از فاز بعدی شبیهسازیهای بیدرنگ Omniverse

در بخش تولید، NVIDIA طرح Omniverse را برای دوقلوهای دیجیتال CAE در زمان واقعی معرفی کرد که اکنون در دسترس است. این خط لوله مرجع جدید نشان میدهد که چگونه محققان یا سازمانها میتوانند شبیهسازیها و تجسمهای بیدرنگ، از جمله آزمایش تونل باد مجازی در زمان واقعی را تسریع بخشند.

Omniverse Blueprint for Real-Time CAE Digital Twins که بر روی میکروسرویسهای NIM AI NVIDIA ساخته شده است، به شبیهسازیهایی که معمولاً هفتهها یا ماهها طول میکشد اجازه میدهد در زمان واقعی انجام شوند. این قابلیت در SC’24 نمایش داده می شود، جایی که Luminary Cloud نشان می دهد که چگونه می توان از آن در شبیه سازی دینامیک سیال استفاده کرد.

جنسن هوانگ، بنیانگذار و مدیر عامل انویدیا، در بیانیه ای مطبوعاتی گفت: “ما Omniverse را ساخته ایم تا همه چیز بتواند یک دوقلو دیجیتال داشته باشد.”

Ajei Gopal، رئیس و مدیر عامل Ansys در همین بیانیه مطبوعاتی گفت: «با ادغام NVIDIA Omniverse Blueprint با نرمافزار Ansys، ما به مشتریان خود امکان میدهیم شبیهسازیهای پیچیده و دقیقتر را سریعتر و دقیقتر انجام دهند.

به روز رسانی کتابخانه CUDA-X به تحقیقات علمی سرعت می بخشد

کتابخانههای CUDA-X NVIDIA به تسریع شبیهسازی بلادرنگ کمک میکنند. این کتابخانه ها همچنین به روز رسانی هایی را دریافت می کنند که تحقیقات علمی را هدف قرار می دهد، از جمله تغییرات در CUDA-Q و انتشار نسخه جدید cuPyNumeric.

عملکرد شبیهسازی دینامیک در CUDA-Q، پلتفرم توسعه NVIDIA برای ساخت رایانههای کوانتومی گنجانده خواهد شد. هدف این است که شبیه سازی های کوانتومی را در زمان های عملی انجام دهیم – مانند یک ساعت به جای یک سال. هریس گفت، گوگل با NVIDIA کار میکند تا نمایشهایی از کیوبیتهای خود را با استفاده از CUDA-Q ایجاد کند و آنها را به هدف دستیابی به محاسبات کوانتومی در مقیاس بزرگ نزدیکتر کند.

انویدیا همچنین آخرین نسخه cuPyNumeric، کتابخانه محاسباتی تحقیقات علمی تسریع شده را معرفی کرد. cuPyNumeric که برای تنظیمات علمی که اغلب از برنامههای NumPy استفاده میکنند و بر روی یک گره فقط CPU اجرا میشوند، طراحی شده است، به آن پروژهها اجازه میدهد تا هزاران GPU با حداقل تغییرات کد، مقیاس شوند. در حال حاضر در موسسات تحقیقاتی منتخب مورد استفاده قرار می گیرد.

منبع: https://www.techrepublic.com/article/nvidia-ai-supercomputing-2024/