نویسنده (ها): Padmaja Kulkarni

در ابتدا منتشر شده در به سمت هوش مصنوعیبشر

هنگامی که بیشتر تیم ها در مورد “هوش مصنوعی یا خطر داده” صحبت می کنند ، مکالمه همیشه به سمت دقت ، کیفیت داده ها یا زیرساخت های مقیاس پذیر حرکت می کند. مهم ، مطمئناً اما تقریباً هرگز دلیل واقعی پروژه ها فرو نمی روند.

حقیقت ناراحت کننده تر است: پروژه های هوش مصنوعی و داده نه در آزمایشگاه بلکه در نمودار ارگ می میرند. من این دست اول را در پروژه هایی دیده ام که از نظر فنی بی عیب و نقص به نظر می رسند اما هرگز در این تجارت فرود نیامده است. داده های گارتنر آن را تأیید می کند – عدم تراز ، مدیریت تغییر و مالکیت قاتلان واقعی هستند.

اگر به اثبات بیشتری احتیاج دارید ، فقط نگاه کنید IBM Watson Healthبشر این سیستم به عنوان یک انقلاب در انکولوژی مورد استقبال قرار گرفت. به عنوان دستیار پزشک که می تواند معالجه با دقت نزدیک انسان را توصیه کند ، قرار گرفت. این فناوری به خودی خود چشمگیر بود ، اما بیمارستان ها برای ادغام آن تلاش کردند. پزشکان به توصیه ها بی اعتماد بودند ، گردش کار دوباره طراحی نشده بود ، و رهبری اغلب با آن به عنوان پیچ در آزمایش رفتار می کرد و نه یک استراتژی. تا سال 2022 ، IBM Watson Health را برای قطعات فروخت. نه به این دلیل که مدل ها در آزمایشگاه شکست خوردند ، بلکه به این دلیل است که شکاف فرزندخواندگی هرگز در عمل بسته نشده بودبشر

مورد 1: مدلی که هیچ کس از آن استفاده نکرد

چند سال پیش ، من بر روی یک ابتکار اصلی داده ها کار کردم: تثبیت چارچوب های گزارش دهی برای ایجاد یک منبع حقیقت. روی کاغذ ، همه چیز را داشت – یک مورد تجاری قوی ، تقاضای واضح برای هماهنگی داده ها و حتی پشتوانه مدیرعامل.

اما در عمل ، تقریباً هیچ کس از آن برای هدف طراحی شده خود استفاده نکرد. بیش از 90 ٪ گزارش ها پس از عرضه محصول هنوز در اکسل ساخته شده بودند.

با نگاهی به عقب ، مشکل فنی نبود. مدل های BI خوب کار کردند ، و خط لوله داده آنچه را که قول داده ایم تحویل داد. ما حتی با توجه به اینکه بیشتر به انسان در حلقه و داشتن حرف نهایی وابسته بودیم ، برای دقت بسیار بالایی طراحی کرده بودیم. چالش واقعی جامعه شناسی بود: تیم ها آماده تغییر عادات گزارشگری خود نبودند و ما در جریان روزانه خود محصولات را یکپارچه نمی کردیم. رهبران با معنای “موفقیت” در واقع تراز نشده بودند. راه های میراث کار باعث می شود تا مردم را به سمت گردش کار قدیمی برگردانند.

این پروژه یک درس سخت را به من آموخت: حتی پروژه ها و مدل های داده با بهترین طراحی بدون تصویب بی ارزش هستند. فناوری از نظر تئوری مشکلات را حل می کند ، اما این رفتار سازمانی است که تصمیم می گیرد زندگی کند یا می میرد.

مورد 2: یک شروع ناقص که مقیاس شده است

چندی نگذشت ، من بازی مخالف را دیدم. برای یک محصول AI دیگر که من به آن کمک کردم ، پرتاب خشن شروع شد. این یک پروژه تحول آمیز برای ساخت و ساز بود سیستم های توصیهبشر این مدل و معماری بهترین چیزی نبود که می توانست باشد ، اما اولویت استقرار و تصویب نسخه MVP و جمع آوری اثبات در بازار متعدد بود!

اما این بار ، رهبری فرزندخواندگی را انجام داد غیر موجهبشر دقت در حال پیگیری پذیرش و درآمد به تنهایی بود و همه در KPI ها تراز می شدند. روال ها به مرحله رسیدگی شدند ، بنابراین یک بازار لرزان کل ابتکار عمل را محکوم نکرد. آموزش و مشوق ها ساخته شده است. استراتژی واضح بود – برای یادگیری و تکرار سریع در نسخه MVP و مقیاس آن در سطح جهان.

از آنجا که سازمان همچنان ادامه داشت – و با آن به عنوان استراتژی رفتار می کرد ، نه یک آزمایش جانبی ، فرزندخواندگی رشد کرد. و محصول مقیاس و ارزش اثبات شده ، و در ماه های آینده بهینه شد. طی یک سال ، در چند بازار زندگی می کرد و بیش از ده میلیون یورو در Uplift کمک می کرد.

این تجربه کنتراست را روشن کرد: موفقیت کمتر به دقت و بیشتر به پایداری و مردم بستگی داشت.

چارچوب اتخاذ برای بستن شکاف پذیرش AI

من آمده ام که به چالش اصلی فکر کنم شکاف پذیرش – فضای خمیازه بین کاری که یک مدل می تواند انجام دهد و یک سازمان مایل به تغییر است. بستن این شکاف بسیار مهم است. دقت بدون فرزندخواندگی فراری در جاده های خاکی است: چشمگیر روی کاغذ ، اما در عمل بی فایده است. پروژه های هوش مصنوعی نه به دلیل مدل های کامل موفق می شوند ، بلکه به این دلیل که سازمان ها آنها را در آغوش می گیرند.

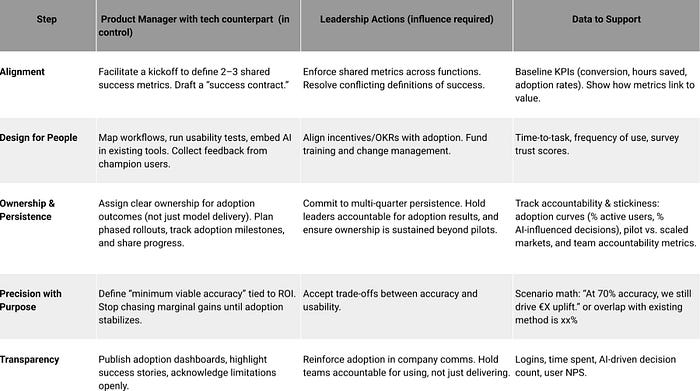

براساس تجربه من ، من شروع به پرسیدن این پنج سؤال اساسی قبل و در حین اعدام کردم – هرگز خیلی دیر نیست! این سؤالات مستقیماً با پنج ستون چارچوب Adopt مطابقت دارد ، مجموعه ای از سؤالاتی که من در چندین بار برای مدت زمان پروژه روشن و تراز می کنم و دوباره بررسی می کنم و از این چارچوب برای تشدید برای کمک استفاده می کنم.

- تراز (الف): آیا ما در مورد موفقیت در واقع هماهنگ هستیم؟ بدون معیارهای مشترک ، تیم هایی با تعاریف متناقض از موفقیت ، پروژه را از هم جدا می کنند.

- طراحی برای افراد (د): چرا مردم از این استفاده می کنند؟ راه حل باید برای کاربران دنیای واقعی طراحی شود و در گردش کار موجود خود تعبیه شود تا از اصطکاک که باعث پذیرش می شود جلوگیری شود.

- مالکیت و پایداری (O): چه کسی صاحب فرزندخواندگی است و آیا رهبری با این یک استراتژی بلند مدت رفتار می کند تا یک آزمایش چشمک زن؟ بدون مالکیت و تعهد پایدار ، حتی خلبانان امیدوار کننده رها می شوند.

- دقت با هدف (P): آیا مدل به اندازه کافی خوب است تا بتواند یک مشکل واقعی را حل کند و اکنون ارزش را ارائه دهد؟ هدف این است که برای هدف مناسب باشد ، نه تعقیب سودهای حاشیه ای در دقت با هزینه ROI.

- شفافیت (T): آیا پیشرفت به خوبی و آشکارا ارتباط برقرار می شود؟ برجسته کردن موفقیت ها ، تصدیق محدودیت ها و به اشتراک گذاری نتایج باعث می شود تیم ها هم تراز و رهبری را درگیر کنند.

در دنیای واقعی اتخاذ کنید

– وقتی همه 5 ستون خط می کشند: در تجربه من (مورد 2) (مورد 2 در بالا)

وقتی من به راه اندازی یک کمک کردم سیستم توصیه، مدل اولیه اساسی بود و معماری پایان به پایان بهترین چیزی نبود که می توانست باشد. تمرکز اصلی روی چرخش و فرزندخواندگی بود

- تراز: KPI ها صریح بودند – نرخ پذیرش و افزایش درآمد ، نه فقط دقت مدل.

- طراحی برای مردم: توصیه ها مستقیماً در جریان خرید موجود تعبیه شده اند ، بنابراین کاربران نیازی به تغییر رفتار ندارند.

- مالکیت و پایداری: یک مالک روشن ، نقاط عطف فرزندخواندگی را ردیابی کرد و رهبری از این امر حمایت کرد ، حتی وقتی یک خلبان لرزان بود.

- دقت هدفمند: این در “به اندازه کافی خوب” حمل شد و ROI را ابتدا اثبات کرد و بعداً بهینه سازی و گسترش یافت.

- شفافیت: نتایج فاز به طور آشکار به اشتراک گذاشته شد ، که تیم ها را تراز و رهبری نگه می داشت.

از آنجا که فرزندخواندگی به عنوان استراتژی رفتار می شد و نه یک آزمایش جانبی – سیستم در سطح جهان مقیاس می شد و ارزش قابل اندازه گیری را تحویل می داد.

موازی: آمازون موتورهای رشد خود را به همین ترتیب ساخت. آنها در اوایل راه اندازی شدند ، با محوریت فرزندخواندگی ، و به توصیه کنندگان در سطح جهانی تکرار شدند. وقتی آمازون به هلند آمد ، من به وضوح به یاد می آورم که از توصیه ها ناامید شده ام ، اما از زمان تکراری بسیار بهبود یافته است!

❌ جایی که از هم جدا می شود

- تراز: جریان های NHS DeepMind ابزار آسیب دیدگی کلیه از نظر فنی قوی بود ، اما موفقیت هرگز برای پزشکان ، تنظیم کننده ها و بیماران به همان روش تعریف نشده است. بدون KPI های مشترک ، تصویب با وجود دقت فروپاشید (سرپرستبا کوربریج). همچنین ، این همان مورد با پروژه گزارش دهی که ذکر کردم همان مورد بود. با این حال ، در تکرارهای بعدی ، تراز روی آن متمرکز شد ، و با موفقیت بیش از دو برابر تعداد بازارها از آنچه در ابتدا تصور می شد ، انجام شد.

- طراحی برای مردم: مایکروسافت تای نشان داد که وقتی AI برای کاربران دنیای واقعی طراحی نشده است چه اتفاقی می افتد. در توییتر بدون حفاظت راه اندازی شد ، طی چند ساعت ربوده شد و خاموش شد (بی بی سی).

- مالکیت و پایداری: همانطور که در بالا ذکر شد ، IBM واتسون برای انکولوژی فاقد مالکیت واضح در بیمارستان ها بود. پزشکان به آن اعتماد نکردند ، Admins آن را اجرا نکردند ، و رهبری IBM پس از خلبانان لرزان آن را رها کرد (اخبار).

- دقت هدفمند: پیشنهادات Zillow دقت پیش بینی شده در قیمت خانه را تعقیب کرد اما متناسب با گردش کار و پذیرش فروشنده را نادیده گرفت. میلیاردها دلار گم شده وقتی مدل به تمرین ترجمه نشد (CNBC).

- شفافیت: کاما، یک ابزار به ثمر رساندن ریسک در دادگاه های ایالات متحده ، به عنوان یک جعبه سیاه فعالیت می کند. هنگامی که تعصب مربوط به ظاهر شدن است ، عدم شفافیت باعث از بین رفتن اعتماد و مشروعیت می شود (قبیله).

پیشخدمت

بزرگترین خطر در هوش مصنوعی صحت نیست – این پذیرش است. مدل ها می توانند در هفته ها ساخته شوند ، اما تغییر نحوه کار مردم سالها طول می کشد. به همین دلیل است که حتی مدل های درخشان وقتی فقط یک ستون اتخاذ مفقود می شوند ، شکست می خورند و به همین دلیل همه افراد ناقص موفق می شوند.

قانون شست ساده است: PMS با داده ها پذیرش قابل مشاهده است. رهبران با پایداری ، فرزندخواندگی را واقعی می کنند. از دست رفته ، و شکاف باز می ماند. پس دفعه بعد کسی می پرسد ، “مدل چقدر دقیق است؟”، در عوض بپرسید: “آیا ما آماده اتخاذ آن هستیم؟

منتشر شده از طریق به سمت هوش مصنوعی